Erste Schritte mit Procore Analytics 2.0

Inhaltsverzeichnis

- Procore Analytics Cloud-Konnektor

- Beginnen Sie mit dem Setup

- Auswählen einer Datenverbindungsmethode

- Herstellen einer Verbindung mit Power BI Desktop

- Herstellen einer Verbindung mit SQL Server mithilfe von Python (SSIS)

- Herstellen einer Verbindung mit SQL Server mithilfe der Python-Bibliothek

- Herstellen einer Verbindung mit SQL Server mithilfe von Python Spark

- Herstellen einer Verbindung mit ADLS mithilfe von Azure Functions

- Herstellen einer Verbindung mit ADLS mithilfe von Python

- Herstellen einer Verbindung mit ADLS mithilfe von Spark

- Herstellen einer Verbindung mit Fabric Lakehouse mithilfe von Data Factory

- Herstellen einer Verbindung mit Fabric Lakehouse mithilfe von Fabric-Notizbüchern

- Herstellen einer Verbindung mit SQL Server mithilfe von Azure Functions

- Herstellen einer Verbindung mit SQL Server mithilfe von Data Factory

- Herstellen einer Verbindung mit SQL Server mithilfe von Fabric Notebook

- Herstellen einer Verbindung mit Databricks

- Herstellen einer Verbindung mit Snowflake mithilfe von Python

- Herstellen einer Verbindung mit Amazon S3 mithilfe von Python

- Bauen Sie Ihre eigene Verbindung auf

Procore Analytics Cloud-Konnektor

Einleitung

Cloud Connector ist die Art und Weise, wie Procore Daten, Informationen und Analysen mit seinen Kunden teilt. Dies kann direkt an Reporting-Tools wie Power BI oder Tableau weitergegeben werden. Sie können auch für Data Warehouses, Stores, Lakes oder andere Anwendungen der Kunden freigegeben werden. Kunden können sogar programmgesteuerten Zugriff auf ihre Daten mit Cloud Connector erstellen, um eine echte Automatisierung zu erzielen. Cloud Connector basiert auf dem offenen Freigabeprotokoll von Delta Share.

Procore Analytics 2.0 Optionen für geführte Datenkonnektoren

Delta Sharing ist das branchenweit erste offene Protokoll für den sicheren Datenaustausch, das den Datenaustausch mit anderen Unternehmen vereinfacht, unabhängig davon, welche Computerplattformen sie verwenden. Viele Anwendungen können mit Delta Share auf Daten zugreifen. Um das Kundenerlebnis jedoch weiter zu verbessern, hat Procore Konnektoren, vorgefertigten Code und Leitfäden für die folgenden Plattformen hinzugefügt, um die Einrichtungszeit und Komplexität zu reduzieren und eine nahtlose, sofort einsatzbereite Verbindung zu ermöglichen.

- SQL Server

- SSIS-Python

- Python-Bibliothek

- Python Spark

- Azurblau

- ADLS Azure Functions

- ADLS-Python

- ADLS Spark

- Lakehouse Fabric Data Factory

- Lakehouse Notizbuch aus Stoff

- SQL Server Azure-Funktionen

- SQL Server Fabric Data Factory

- SQL Server Fabric-Notebook

- Databricks

- Schneeflocke

- Amazon S3

- Anleitungen, um Ihre eigenen zu schreiben (GitHub)

Weitere Datenkonnektoren folgen in Kürze!

Zugriff auf Dokumentation und Code

Umfassende Dokumentationen und Codebeispiele sind im Produkt Procore Analytics direkt in der Procore-Webanwendung verfügbar, auf die Ihre Procore-Administratoren zugreifen können. Diese Ressourcen enthalten Schritt-für-Schritt-Anleitungen, Codeausschnitte und bewährte Praktiken, die Sie bei der Einrichtung und Verwaltung Ihrer Datenintegration unterstützen.

Nächste Schritte

Fahren Sie mit dem nächsten Abschnitt dieser Anleitung fort, um mit dem Einrichtungsprozess zu beginnen.

Wenn Sie weitere Fragen oder Unterstützung benötigen, wenden Sie sich bitte an Ihren Kundenbetreuer oder unser Support-Team.

Überprüfen von Berechtigungen

Hinweis

- Sie müssen das Analytics-Tool auf Unternehmensebene für das Procore-Konto Ihres Unternehmens aktiviert haben.

- Jeder, der über "Admin"-Zugriff auf das Analytics-Tool verfügt, kann zusätzlichen Benutzern Zugriff auf das Analytics-Tool gewähren.

- Benutzer müssen über "Admin"-Zugriff auf das Analytics-Tool verfügen, um ein Zugriffstoken generieren zu können.

- Es kann bis zu 24 Stunden dauern, bis Änderungen an den Berechtigungen eines Benutzers im Adressbuch für Analytics wirksam werden.

Sie müssen sicherstellen, dass die entsprechenden Berechtigungen zugewiesen sind, um ein Zugriffstoken zu generieren, damit Sie Ihre Procore-Daten mit Ihrer BI-Lösung verbinden können. Der Zugriff auf Analytics ist mit Ihren Procore-Anmeldedaten verknüpft, sodass Sie ein einzelnes Zugriffstoken generieren können. Das Zugriffstoken ist eine Ziffernfolge, die Sie in Ihr BI-System eingeben, um auf Daten zuzugreifen.

In der Regel handelt es sich bei Benutzern, die Zugriffstoken benötigen, um Data Engineers oder Power BI-Entwickler. Wenn Sie in mehreren Unternehmen Zugriff auf Analytics haben, können Sie mit Ihrem Token Daten von allen Unternehmen abrufen. Der Token ist an Sie gebunden, nicht an ein bestimmtes Unternehmen, so dass er für alle Unternehmen, auf die Sie Zugriff haben, gleich bleibt.

Unternehmens- und Projektadministratoren erhalten standardmäßig eine Admin-Rolle. Die folgenden Benutzerzugriffsebenen sind für das Analytics-Tool zulässig:

- Nichts: Kein Zugriff auf Analytics-Daten.

- Admin: Hat volle Zugriffsrechte auf Daten für alle Tools und Projekte (mit Ausnahme bestimmter als privat gekennzeichneter Daten wie Korrespondenzdaten ).

Es gibt zwei Möglichkeiten, einzelnen Benutzern Berechtigungen zuzuweisen:

Widerrufen des Zugriffs

Der Zugriff auf Daten im Analytics-Tool wird widerrufen, wenn einem Benutzer die Berechtigungen für das Tool entzogen werden. Wenn der Kontaktdatensatz eines Nutzers inaktiv wird, verliert er außerdem den Zugriff auf Analytics-Daten.

Generieren von Anmeldeinformationen für den Datenzugriff

Um mit dem Zugriff auf Ihre Procore-Daten zu beginnen, gibt es zwei Optionen zum Generieren Ihrer Anmeldedaten für den Datenzugriff: die direkte Databricks-Verbindungsmethode oder die Delta-Freigabetokenmethode. Das Zugriffstoken ist eine Ziffernfolge, die Sie in den entsprechenden Datenkonnektor eingeben, um auf Daten zuzugreifen.

Überlegungen

- Sie müssen das Procore Analytics-Tool aktiviert haben.

- Standardmäßig haben alle Unternehmensadministratoren "Admin"-Zugriff auf Analytics im Adressbuch.

- Jeder, der über "Admin"-Zugriff auf Analytics verfügt, kann weiteren Benutzern Zugriff auf das Analytics-Tool gewähren.

- Benutzer müssen über "Admin"-Zugriff auf das Analytics-Tool verfügen, um ein Datentoken generieren zu können.

Schritte

- Melden Sie sich bei Procore an.

- Klicken Sie auf das Symbol Konto und Profil im oberen rechten Bereich der Navigationsleiste.

- Klicken Sie auf Meine Profileinstellungen.

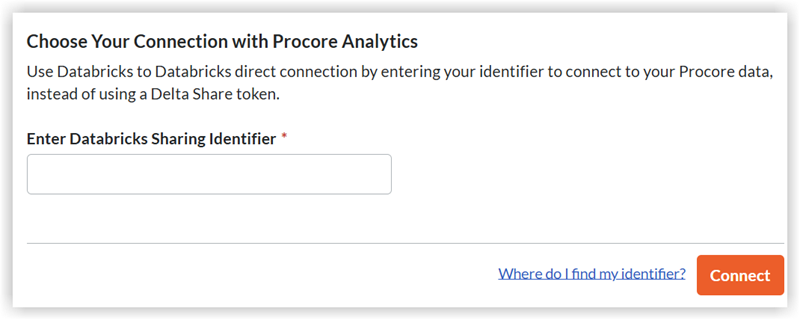

- Unter Wählen Sie Ihre Verbindung mit Procore Analyticshaben Sie zwei Möglichkeiten, Anmeldedaten zu generieren:

- Databricks stellt eine direkte Verbindung her ODER generiert ein persönliches Zugriffstoken mit Delta Share.

- Geben Sie Ihren Databricks-Freigabebezeichner für die direkte Databricks-Verbindungsmethode ein, und klicken Sie dann auf Verbinden. Weitere Informationen finden Sie unter Verbinden Ihrer Procore-Daten mit einem Databricks-Arbeitsbereich.

- Wählen Sie für die Tokenmethode Delta-Freigabetoken aus.

- Stellen Sie sicher, dass Sie ein Ablaufdatum wählen.

- Klicken Sie auf Token generieren.

Wichtig! Es wird empfohlen, dass Sie Ihr Token kopieren und speichern, um später darauf zurückgreifen zu können, da Procore keine Token für Benutzer speichert. - Sie verwenden Ihr Bearertoken, Ihren Freigabenamen, die URL des Delta-Freigabeservers und die Version Ihrer Freigabeanmeldeinformationen, um auf Ihre Daten zuzugreifen und diese zu integrieren.

- In den zusätzlichen Abschnitten des Handbuchs "Erste Schritte" finden Sie die nächsten Schritte zum Verbinden Ihrer Daten basierend auf der gewünschten Datenverbindungsmethode.

Hinweis

- Das Token verschwindet nach einer Stunde oder es verschwindet auch, wenn Sie die Seite verlassen. Um ein neues Token zu generieren, kehren Sie zu Schritt 1 zurück.

- Es kann bis zu 24 Stunden dauern, bis die Daten sichtbar werden.

- Bitte generieren Sie Ihr Token während dieser Verarbeitungszeit nicht neu, da dies zu Problemen mit Ihrem Token führen kann.

Hochladen von Berichten in Power BI (falls zutreffend)

- Navigieren Sie über das Menü "Unternehmenstools" zu Procore Analytics .

- Wechseln Sie zum Abschnitt Erste Schritte .

- Wählen Sie unter Power BI-Dateien die verfügbaren Power BI-Berichte aus, und laden Sie sie herunter.

- Melden Sie sich mit Ihren Power BI-Anmeldedaten beim Power BI-Dienst an.

- Erstellen Sie einen Arbeitsbereich, in dem Sie die Procore Analytics-Berichte Ihres Unternehmens speichern möchten. Weitere Informationen finden Sie in der Power BI-Supportdokumentation von Microsoft.

Notizen: Es können Lizenzierungsanforderungen gelten. - Klicken Sie im Arbeitsbereich auf Hochladen.

- Klicken Sie nun auf Durchsuchen.

- Wählen Sie die Berichtsdatei an ihrem Speicherort auf Ihrem Computer aus und klicken Sie auf Öffnen.

- Nachdem Sie die Datei hochgeladen haben, klicken Sie auf Filter und wählen Sie Semantisches Modell.

- Bewegen Sie den Mauszeiger über die Zeile mit dem Namen des Berichts und klicken Sie auf das Symbol der vertikalen Ellipse

.

. - Klicken Sie auf Einstellungen.

- Klicken Sie auf der Einstellungsseite auf Datenquellen Anmeldedaten und dann auf Anmeldeinformationen bearbeiten.

- Führen Sie im angezeigten Fenster "[Berichtsname] konfigurieren" die folgenden Schritte aus:

- Authentifizierungsmethode: Wählen Sie "Schlüssel".

- Kontoschlüssel: Geben Sie den Token ein, den Sie von der Seite zur Tokengenerierung in Procore erhalten haben.

- Einstellung der Datenschutzstufe für diese Datenquelle: Wählen Sie die Datenschutzstufe aus. Wir empfehlen, "Privat" oder "Organisatorisch" zu wählen. Weitere Informationen zu den Datenschutzstufen finden Sie in der Power BI-Supportdokumentation von Microsoft.

- Klicken Sie auf Anmelden.

- Klicken Sie auf Refresh und gehen Sie wie folgt vor :

- Zeitzone: Wählen Sie die Zeitzone aus, die Sie für geplante Datenaktualisierungen verwenden möchten.

- Stellen Sie unter Aktualisierungszeitplan konfigurieren den Umschalter auf die Position EIN.

- Aktualisierungshäufigkeit: Wählen Sie "Täglich".

- Uhrzeit: Klicken Sie auf Weitere Uhrzeit hinzufügen und wählen Sie 7:00 Uhr aus.

Anmerkung: Sie können bis zu 8 Aktualisierungszeiten hinzufügen. - Optional:

- Markieren Sie das Kontrollkästchen "Benachrichtigungen über Aktualisierungsfehler an den Eigentümer des Datasets senden", um Benachrichtigungen über Aktualisierungsfehler zu senden.

- Geben Sie die E-Mail-Adressen aller anderen Kollegen ein, an die das System Benachrichtigungen über Aktualisierungsfehler senden soll.

- Klicken Sie auf Übernehmen.

- Um zu überprüfen, ob die Einstellungen korrekt konfiguriert wurden und ob die Daten des Berichts ordnungsgemäß aktualisiert werden, kehren Sie zur Seite "Filtern und Semantisches Modell auswählen" zurück und führen Sie die folgenden Schritte aus:

- Bewegen Sie den Mauszeiger über die Zeile mit dem Namen des Berichts und klicken Sie auf das kreisförmige Pfeilsymbol, um die Daten manuell zu aktualisieren.

- Überprüfen Sie die Spalte "Aktualisiert", um zu sehen, ob ein Warnsymbol

angezeigt wird.

angezeigt wird.

- Wenn kein Warnsymbol angezeigt wird, wurden die Daten des Berichts erfolgreich aktualisiert.

- Wenn ein Warnsymbol angezeigt wird, ist ein Fehler aufgetreten. Klicken Sie auf das Warnsymbol

, um weitere Informationen zu dem Fehler anzuzeigen.

, um weitere Informationen zu dem Fehler anzuzeigen.

- Führen Sie die folgenden Schritte aus, um das leere Dashboard zu löschen, das der Power BI-Dienst automatisch erstellt hat:

- Bewegen Sie den Mauszeiger über die Zeile mit dem Namen des Dashboards. Klicken Sie auf das Ellipsensymbol

und dann auf Löschen.

und dann auf Löschen.

- Bewegen Sie den Mauszeiger über die Zeile mit dem Namen des Dashboards. Klicken Sie auf das Ellipsensymbol

- Um zu überprüfen, ob der Bericht ordnungsgemäß gerendert wird, navigieren Sie zur Seite "Alle" oder "Inhalt", und klicken Sie auf den Namen des Berichts, um den Bericht im Power BI-Dienst anzuzeigen.

Tipp

Verweisen Sie auf die Spalte "Typ", um sicherzustellen, dass Sie auf den Bericht und nicht auf ein anderes Asset klicken.

- Wiederholen Sie die obigen Schritte in Power BI für jede Procore Analytics-Berichtsdatei.

Herstellen einer Verbindung mit Power BI Desktop

Hinweis

Diese Verbindungsmethoden werden in der Regel von Datenexperten verwendet.Neue Daten verbinden

- Öffnen Sie Ihren Power BI Desktop.

- Klicken Sie auf Daten abrufen und wählen Sie Mehr.

- Geben Sie in die Suchleiste "Delta Sharing" ein.

- Wählen Sie "Delta-Freigabe" und klicken Sie dann auf "Verbinden".

- Geben Sie die URL des Delta-Sharing-Servers, die Sie von Procore erhalten haben, ein oder fügen Sie sie ein.

- Klicken Sie auf OK.

- Wenn Sie zum ersten Mal eine Verbindung zu dieser Quelle herstellen, werden Sie aufgefordert, Ihr Delta Sharing Bearer Token anzugeben.

- Klicken Sie auf Verbinden.

- Wählen Sie nach der Authentifizierung die Procore Analytics Tabellen aus, die Sie in Ihren Power BI-Bericht aufnehmen möchten.

- Wählen Sie Laden aus, um Ihren Bericht anzuzeigen, oder wählen Sie Daten transformieren aus, um weitere Transformationen in Power Query vorzunehmen.

Herstellen einer Verbindung mit einer vorhandenen Vorlage

- Öffnen Sie Power BI Desktop.

- Klicken Sie auf die Dropdown-Liste Daten transformieren und wählen Sie Datenquelleneinstellungen aus.

- Wählen Sie Berechtigungen bearbeiten aus.

- Klicken Sie auf Bearbeiten.

- Geben Sie das Token ein, das Sie von Analytics 2.0 erhalten haben.

- Klicken Sie auf Aktualisieren.

- Ihre benutzerdefinierten Budgetspalten werden jetzt in den Tabellen "Budget" und "BudgetSnapshots" angezeigt.

Herstellen einer Verbindung mit SQL Server mithilfe von Python (SSIS)

Übersicht

Das Procore Analytics Cloud Connect Access Tool ist eine Befehlszeilenschnittstelle (CLI), mit der Sie Datenübertragungen von Procore zu MS SQL Server konfigurieren und verwalten können. Es besteht aus zwei Hauptkomponenten:

- user_exp.py (Dienstprogramm zur Konfigurationseinrichtung)

- delta_share_to_azure_panda.py (Skript zur Datensynchronisation)

Voraussetzungen

- Python und pip sind auf Ihrem System installiert.

- Zugriff auf Procore Delta Share.

- Anmeldedaten für das MS SQL Server-Konto.

- Erforderliche Abhängigkeiten installieren: pip install -r requirements.txt.

Schritte

- Erstkonfiguration

- Daten-Synchronisation

- Konfiguration der Delta-Freigabe

- MS SQL Server-Konfiguration

- SSIS-Konfiguration

Erstkonfiguration

- Führen Sie das Konfigurationsdienstprogramm aus:

Python-user_exp.py

Dies wird Ihnen bei der Einrichtung helfen:

- Konfiguration der Delta Share-Quelle

- MS SQL Server-Zielkonfiguration

- Einstellungen für die Terminplanung

Daten-Synchronisation

Nach der Konfiguration haben Sie zwei Möglichkeiten, die Datensynchronisierung auszuführen:

- Python für die direkte Ausführung

delta_share_to_azure_panda.py

ODER - Geplante Ausführung

Wenn Sie dies während des Setups konfigurieren, wird der Auftrag automatisch gemäß Ihrem Cron-Zeitplan ausgeführt.

Konfiguration der Delta-Freigabe

- Erstellen Sie eine neue Datei mit dem Namen config.share mit Ihren Delta Share-Anmeldedaten im JSON-Format.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxxxx",

"endpoint": "https://nvirginia.cloud.databricks.c...astores/xxxxxx

}

- Abrufen von Pflichtfeldern:

Anmerkung: Diese Details können über die Procore Analytics-Webanwendung abgerufen werden.- ShareCredentialsVersion: Versionsnummer (derzeit 1).

- BearerToken: Ihr Delta Share-Zugriffstoken.

- Endpunkt: Die URL Ihres Delta Share-Endpunkts.

- Speichern Sie die Datei an einem sicheren Ort.

- Bei der Konfiguration der Datenquelle werden Sie aufgefordert, Folgendes anzugeben:

- Liste der Tabellen (durch Kommas getrennt).

- Lassen Sie das Feld leer, um alle Tabellen zu synchronisieren.

- Beispiel: 'table1, t able2, table3'.

- Pfad zu Ihrer 'config.share' Datei.

MS SQL Server-Konfiguration

Sie müssen die folgenden MS SQL Server-Details angeben:

- Datenbank

- Gastgeber

- Passwort

- Schema

- Nutzername

SSIS-Konfiguration

- Navigieren Sie über die Befehlszeile zu dem Ordner, indem Sie'cd'<path to the folder> eingeben.

- Installieren Sie die erforderlichen Pakete mit 'pip install -r requirements.txt' oder 'python -m pip install -r requirements.txt'.

- Öffnen Sie SSIS, und erstellen Sie ein neues Projekt.

- Ziehen Sie aus der SSIS-Toolbox die Aktivität "Prozessaufgabe ausführen" per Drag & Drop.

- Doppelklicken Sie auf "Prozessaufgabe ausführen" und navigieren Sie zur Registerkarte Verarbeiten.

- Geben Sie unter "Ausführbare Datei" den Pfad ein, um im Python-Installationsordner zu python.exe.

- Geben Sie in 'WorkingDirectory' einen Pfad zu dem Ordner ein, der das Skript enthält , das Sie ausführen möchten (ohne den Namen der Skriptdatei).

- Geben Sie unter 'Argumente' den Namen des Skripts 'delta_share_to_azure_panda.py' ein, die Sie mit dem .py ausführen möchten zu erweitern und zu speichern.

- Klicken Sie auf die Schaltfläche "Start" im oberen Bereich:

- Während der Ausführung der Aufgabe wird die Ausgabe der Python-Konsole im Fenster der externen Konsole angezeigt.

- Sobald die Aufgabe erledigt ist, wird ein grünes Häkchen angezeigt:

Herstellen einer Verbindung mit SQL Server mithilfe der Python-Bibliothek

Übersicht

Dieser Leitfaden enthält detaillierte Anweisungen zur Einrichtung und Verwendung des Delta Sharing-Integrationspakets auf einem Windows-Betriebssystem , um Daten nahtlos in Ihre Workflows mit Procore Analytics zu integrieren. Das Paket unterstützt mehrere Ausführungsoptionen, so dass Sie die gewünschte Konfiguration und Integrationsmethode auswählen können.

Voraussetzungen

Stellen Sie sicher, dass Sie über Folgendes verfügen, bevor Sie fortfahren:

- Procore Analytics 2.0 SKU

- Delta-Sharing-Pofile-Datei:

Rufen Sie Ihre *.share-Datei mit den Anmeldedatenfür die Deltafreigabe ab. Kopieren Sie es der Einfachheit halber in das Paketverzeichnis. - Python-Umgebung: Installieren Sie Python 3 und pip auf Ihrem System.

- Laden Sie Python herunter.

- Alternativ können Sie auch den Microsoft Store verwenden.

Schritte

- Vorbereiten des Pakets

- Installieren von Abhängigkeiten

- Konfiguration generieren

- Konfigurieren von Cron-Jobs und sofortiger Ausführung

- Ausführung und Wartung

Vorbereiten des Pakets

- Erstellen Sie eine neue Datei mit dem Namen config.share mit Ihren Delta Share-Anmeldedaten im JSON-Format.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxxxx",

"endpoint": "https://nvirginia.cloud.databricks.c...astores/xxxxxx

}

- Abrufen von Pflichtfeldern.

Anmerkung: Diese Details können über die Procore Analytics-Webanwendung abgerufen werden.- ShareCredentialsVersion: Versionsnummer (derzeit 1).

- BearerToken: Ihr Delta Share-Zugriffstoken.

- Endpunkt: Die URL Ihres Delta Share-Endpunkts.

- Laden Sie das Paket herunter und extrahieren Sie es.

- Entpacken Sie das Paket in ein Verzeichnis Ihrer Wahl.

- Kopieren Sie die *.share Delta Sharing-Profildatei in das Paketverzeichnis, um den Zugriff zu erleichtern.

Installieren von Abhängigkeiten

- Öffnen Sie ein Terminal im Paketverzeichnis.

- Führen Sie den folgenden Befehl aus, um die Abhängigkeiten zu installieren:

- pip install -r requirements.txt

Konfiguration generieren

- Generieren Sie die Datei config.yaml , indem Sie python user_exp.py ausführen:

Dieses Skript hilft beim Generieren der Datei config.yaml, die die erforderlichen Anmeldedaten und Einstellungen enthält. - Bei der Konfiguration der Datenquelle werden Sie aufgefordert, Folgendes anzugeben:

- Liste der Tabellen (durch Kommas getrennt).

- Lassen Sie das Feld leer, um alle Tabellen zu synchronisieren.

Beispiel: 'Tabelle1, Tabelle2, Tabelle3'. - Pfad zu Ihrer 'config.share' Datei.

- Zum ersten Mal geben Sie Ihre Anmeldedaten wie den Speicherort der Delta Share-Quellkonfiguration, Tabellen, Datenbank, Host usw. an.

Anmerkung: Danach können Sie die Konfiguration manuell oder durch das laufende Python-user_exp.py wiederverwenden oder aktualisieren.

Konfigurieren von Cron-Jobs und sofortiger Ausführung (optional)

- Entscheiden Sie, ob Sie einen Cronjob für die automatische Ausführung einrichten möchten.

- Stellen Sie einen Cron-Zeitplan bereit:

- Format: * * * * * ( Minute, Stunde, Monatstag, Monat, Wochentag).

- Beispiel für die tägliche Ausführung um 2 Uhr morgens: 0 2 * * *

- Um die Planungsprotokolle zu überprüfen, wird die Datei 'procore_scheduling.log' erstellt, sobald die Terminplanung eingerichtet ist.

Sie können die Zeitplanung auch überprüfen, indem Sie den folgenden Befehl im Terminal ausführen:

Für Linux und MacOs:

Bearbeiten/Löschen - Bearbeiten Sie den Terminplanungs-Cron mit:

'''Bash

EDITOR=nano crontab -e

```

- Nachdem Sie den obigen Befehl ausgeführt haben, sollten Sie etwas Ähnliches wie das folgende sehen:

- 2 * * * * /Benutzer/your_user/snowflake/venv/bin/python /Benutzer/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | während der gelesenen Zeile; do echo "$(date) - $line"; Erledigt >> /Benutzer/your_user/snowflake/sql_server_python/procore_scheduling.log # procore-data-import

- Sie können auch den Zeitplan anpassen oder die gesamte Zeile löschen, um zu verhindern, dass sie nach Zeitplan ausgeführt wird.

Für Windows:

- Überprüfen Sie, ob die Terminplanaufgabe erstellt wurde:

'''Powershell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - So bearbeiten/löschen Sie die Planungsaufgabe:

Öffnen Sie den Taskplaner:- Drücken Sie Win + R, geben Sie taskschd.msc ein. und drücken Sie die Eingabetaste.

- Navigieren Sie zu den geplanten Aufgaben.

- Erweitern Sie im linken Bereich die Taskplaner-Bibliothek.

- Suchen Sie nach dem Ordner, in dem Ihre Aufgabe gespeichert ist (z. B. Taskplaner-Bibliothek oder ein benutzerdefinierter Ordner).

- Finden Sie Ihre Aufgabe:

- Suchen Sie nach dem Aufgabennamen ProcoreDeltaShareScheduling.

- Klicken Sie darauf, um die Details im unteren Bereich anzuzeigen.

- Überprüfen Sie den Zeitplan:

- Überprüfen Sie die Registerkarte Trigger, um zu sehen, wann die Aufgabe ausgeführt werden soll.

- Überprüfen Sie die Registerkarte Verlauf, um die letzten Ausführungen zu bestätigen.

- So löschen Sie die Aufgabe:

- Löschen Sie die Aufgabe aus der GUI.

Frage zur sofortigen Ausführung:

- Option zum Ausführen eines Skripts zum Kopieren von Daten unmittelbar nach der Konfiguration.

- Nach dem Generieren der config.yaml, Die CLI kann jederzeit unabhängig ausgeführt werden, indem je nach Paket ein Skript zum Kopieren von Daten ausgeführt wird. Siehe Beispiele unten:

Python-delta_share_to_azure_panda.py

ODER

python delta_share_to_sql_spark.py

ODER

python delta_share_to_azure_dfs_spark.py

Ausführung und Wartung

Häufige Probleme und Lösungen

- Cron Job Einrichtung:

- Stellen Sie sicher, dass die Systemberechtigungen korrekt konfiguriert sind.

- Überprüfen Sie die Systemprotokolle, wenn der Auftrag nicht ausgeführt werden kann.

- Überprüfen Sie, ob das Skript über Ausführungsberechtigungen delta_share_to_azure_panda.py verfügt.

- Konfigurationsdatei:

- Stellen Sie sicher, dass sich die Datei config.yaml im selben Verzeichnis wie das Skript befindet.

- Sichern Sie die Datei, bevor Sie Änderungen vornehmen.

Unterstützen

Für weitere Hilfe:

- Überprüfen Sie die Skriptprotokolle auf detaillierte Fehlermeldungen.

- Überprüfen Sie die Datei config.yaml auf Fehlkonfigurationen.

- Wenden Sie sich an Ihren Systemadministrator, wenn Sie Fragen zu Berechtigungen haben.

- Wenden Sie sich bei Problemen im Zusammenhang mit dem Delta Share-Zugriff an den Procore Support.

- Überprüfen Sie das Protokoll auf fehlgeschlagene Tabellen: failed_tables.log.

Hinweise

- Sichern Sie immer Ihre Konfigurationsdateien, bevor Sie Änderungen vornehmen.

- Testen Sie neue Konfigurationen in einer Nicht-Produktionsumgebung, um Unterbrechungen zu vermeiden.

Herstellen einer Verbindung mit SQL Server mithilfe von Python Spark

Übersicht

Dieser Leitfaden enthält detaillierte Anweisungen zur Einrichtung und Verwendung des Delta Sharing-Integrationspakets auf einem Windows-Betriebssystem , um Daten nahtlos in Ihre Workflows mit Procore Analytics zu integrieren. Das Paket unterstützt mehrere Ausführungsoptionen, so dass Sie die gewünschte Konfiguration und Integrationsmethode auswählen können.

Voraussetzungen

Stellen Sie sicher, dass Sie über Folgendes verfügen, bevor Sie fortfahren:

- Procore Analytics 2.0 SKU

- Delta-Sharing-Pofile-Datei:

Rufen Sie Ihre *.share-Datei mit den Anmeldedatenfür die Deltafreigabe ab. Kopieren Sie es der Einfachheit halber in das Paketverzeichnis. - Python-Umgebung: Installieren Sie Python 3 und pip auf Ihrem System.

- Laden Sie Python herunter.

- Alternativ können Sie auch den Microsoft Store verwenden.

Schritte

- Vorbereiten des Pakets

- Installieren von Abhängigkeiten

- Konfiguration generieren

- Konfigurieren von Cron-Jobs und sofortiger Ausführung

- Ausführung und Wartung

Vorbereiten des Pakets

- Erstellen Sie eine neue Datei mit dem Namen config.share mit Ihren Delta Share-Anmeldedaten im JSON-Format.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxxxx",

"endpoint": "https://nvirginia.cloud.databricks.c...astores/xxxxxx

}

- Abrufen von Pflichtfeldern.

Anmerkung: Diese Details können über die Webanwendung von Procore Analytics abgerufen werden.- ShareCredentialsVersion: Versionsnummer (derzeit 1).

- BearerToken: Ihr Delta Share-Zugriffstoken.

- Endpunkt: Die URL Ihres Delta Share-Endpunkts.

- Laden Sie das Paket herunter und extrahieren Sie es.

- Entpacken Sie das Paket in ein Verzeichnis Ihrer Wahl.

- Kopieren Sie die *.share Delta Sharing-Profildatei in das Paketverzeichnis, um den Zugriff zu erleichtern.

Installieren von Abhängigkeiten

- Öffnen Sie ein Terminal im Paketverzeichnis.

- Führen Sie den folgenden Befehl aus, um die Abhängigkeiten zu installieren:

- pip install -r requirements.txt

Konfiguration generieren

- Generieren Sie die Datei config.yaml , indem Sie python user_exp.py ausführen:

Dieses Skript hilft beim Generieren der Datei config.yaml, die die erforderlichen Anmeldedaten und Einstellungen enthält. - Bei der Konfiguration der Datenquelle werden Sie aufgefordert, Folgendes anzugeben:

- Liste der Tabellen (durch Kommas getrennt).

- Lassen Sie das Feld leer, um alle Tabellen zu synchronisieren.

Beispiel: 'Tabelle1, Tabelle2, Tabelle3'. - Pfad zu Ihrer 'config.share' Datei.

- Zum ersten Mal geben Sie Ihre Anmeldedaten wie den Speicherort der Delta Share-Quellkonfiguration, Tabellen, Datenbank, Host usw. an.

Anmerkung: Danach können Sie die Konfiguration manuell oder durch das laufende Python-user_exp.py wiederverwenden oder aktualisieren.

Konfigurieren von Cron-Jobs und sofortiger Ausführung (optional)

- Entscheiden Sie, ob Sie einen Cronjob für die automatische Ausführung einrichten möchten.

- Stellen Sie einen Cron-Zeitplan bereit:

- Format: * * * * * ( Minute, Stunde, Monatstag, Monat, Wochentag).

- Beispiel für die tägliche Ausführung um 2 Uhr morgens: 0 2 * * *

- Um die Planungsprotokolle zu überprüfen, wird die Datei 'procore_scheduling.log' erstellt, sobald die Terminplanung eingerichtet ist.

Sie können die Zeitplanung auch überprüfen, indem Sie den folgenden Befehl im Terminal ausführen:

Für Linux und MacOs:

Bearbeiten/Löschen - Bearbeiten Sie den Terminplanungs-Cron mit:

'''Bash

EDITOR=nano crontab -e

```

- Nachdem Sie den obigen Befehl ausgeführt haben, sollten Sie etwas Ähnliches wie das folgende sehen:

- 2 * * * * /Benutzer/your_user/snowflake/venv/bin/python /Benutzer/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | während der gelesenen Zeile; do echo "$(date) - $line"; Erledigt >> /Benutzer/your_user/snowflake/sql_server_python/procore_scheduling.log # procore-data-import

- Sie können auch den Zeitplan anpassen oder die gesamte Zeile löschen, um zu verhindern, dass sie nach Zeitplan ausgeführt wird.

Für Windows:

- Überprüfen Sie, ob die Terminplanaufgabe erstellt wurde:

'''Powershell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - So bearbeiten/löschen Sie die Planungsaufgabe:

Öffnen Sie den Taskplaner:- Drücken Sie Win + R, geben Sie taskschd.msc ein. und drücken Sie die Eingabetaste.

- Navigieren Sie zu den geplanten Aufgaben.

- Erweitern Sie im linken Bereich die Taskplaner-Bibliothek.

- Suchen Sie nach dem Ordner, in dem Ihre Aufgabe gespeichert ist (z. B. Taskplaner-Bibliothek oder ein benutzerdefinierter Ordner).

- Finden Sie Ihre Aufgabe:

- Suchen Sie nach dem Aufgabennamen ProcoreDeltaShareScheduling.

- Klicken Sie darauf, um die Details im unteren Bereich anzuzeigen.

- Überprüfen Sie den Zeitplan:

- Überprüfen Sie die Registerkarte Trigger, um zu sehen, wann die Aufgabe ausgeführt werden soll.

- Überprüfen Sie die Registerkarte Verlauf, um die letzten Ausführungen zu bestätigen.

- So löschen Sie die Aufgabe:

- Löschen Sie die Aufgabe aus der GUI.

Frage zur sofortigen Ausführung:

- Option zum Ausführen eines Skripts zum Kopieren von Daten unmittelbar nach der Konfiguration.

- Nach dem Generieren der config.yaml, Die CLI kann jederzeit unabhängig ausgeführt werden, indem je nach Paket ein Skript zum Kopieren von Daten ausgeführt wird. Siehe Beispiele unten:

Python-delta_share_to_azure_panda.py

ODER

python delta_share_to_sql_spark.py

ODER

python delta_share_to_azure_dfs_spark.py

Ausführung und Wartung

Häufige Probleme und Lösungen

- Cron Job Einrichtung:

- Stellen Sie sicher, dass die Systemberechtigungen korrekt konfiguriert sind.

- Überprüfen Sie die Systemprotokolle, wenn der Auftrag nicht ausgeführt werden kann.

- Überprüfen Sie, ob das Skript über Ausführungsberechtigungen delta_share_to_azure_panda.py verfügt.

- Konfigurationsdatei:

- Stellen Sie sicher, dass sich die Datei config.yaml im selben Verzeichnis wie das Skript befindet.

- Sichern Sie die Datei, bevor Sie Änderungen vornehmen.

Unterstützen

Für weitere Hilfe:

- Überprüfen Sie die Skriptprotokolle auf detaillierte Fehlermeldungen.

- Überprüfen Sie die Datei config.yaml auf Fehlkonfigurationen.

- Wenden Sie sich an Ihren Systemadministrator, wenn Sie Fragen zu Berechtigungen haben.

- Wenden Sie sich bei Problemen im Zusammenhang mit dem Delta Share-Zugriff an den Procore Support.

- Überprüfen Sie das Protokoll auf fehlgeschlagene Tabellen: failed_tables.log.

Hinweise

- Sichern Sie immer Ihre Konfigurationsdateien, bevor Sie Änderungen vornehmen.

- Testen Sie neue Konfigurationen in einer Nicht-Produktionsumgebung, um Unterbrechungen zu vermeiden.

Herstellen einer Verbindung mit ADLS mithilfe von Azure Functions

Übersicht

Dieser Leitfaden führt Sie durch das Einrichten und Bereitstellen einer Azure-Funktion für die Integration von Delta Sharing-Daten in Procore Analytics. Die Azure-Funktion ermöglicht effiziente Datenverarbeitungs- und Freigabeworkflows mit Delta Sharing-Profilen.

Voraussetzungen

- Procore Analytics 2.0 SKU.

- Profildatei für die Delta-Freigabe:

- Ihre *.share-Datei mit den Anmeldedatenfür die Deltafreigabe. Legen Sie es der Einfachheit halber in das heruntergeladene Paket.

- Python-Umgebung:

- Sie haben Python 3.9+ und pip auf Ihrem System installiert.

- Azure-Einrichtung:

- Die Azure CLI ist installiert und angemeldet.

- Azure Functions Kerntools installiert.

Schritte

- Prepare the Package

- Install Dependencies

- Generate Configuration

- Azure CLI Setup

- Install Azure Functions Core Tools

- Prepare the Azure Function

- Deployment

- Validation

Vorbereiten des Pakets

- Laden Sie das erforderliche Paket herunter (adls_azure_function oder sql_server_azure_function).

- Extrahieren Sie die Paketdateien in ein lokales Verzeichnis.

- Platzieren Sie die Delta-Sharing-Datei:

- Kopieren Sie Ihre *.share Delta Sharing-Profildatei in das extrahierte Verzeichnis.

Installieren von Abhängigkeiten

- Öffnen Sie ein Terminal im Paketverzeichnis.

- Führen Sie den folgenden Befehl aus, um die erforderlichen Python-Abhängigkeiten zu installieren:

- pip install -r requirements.txt

Konfiguration generieren

- Generieren Sie die Datei config.yaml , indem Sie Folgendes ausführen:

- Python-user_exp.py

- Das Skript fordert Sie auf, Anmeldedaten einzugeben, z. B.:

- Tabellen

- Name der Datenbank

- Gastgeber

- Zusätzliche Anmeldedaten.

- Die Konfiguration kann wiederverwendet oder manuell oder durch erneutes Ausführen von python user_exp.pyaktualisiert werden.

Einrichtung der Azure CLI

- Melden Sie sich bei Azure an.

- Führen Sie den folgenden Befehl aus, um sich anzumelden:

az login - Überprüfen des Azure-Kontos:

- az account show

- Wenn der Befehl az nicht verfügbar ist, installieren Sie die Azure CLI, indem Sie die Anweisungen befolgen, die Sie hier finden: Microsoft Learn.

Installieren von Azure Functions Kerntools

Gehe zu

Hier finden Sie Anweisungen zum Installieren von Azure Functions Kerntools.Vorbereiten der Azure-Funktion

- Verwenden SieSo erstellen Sie Folgendes:

- Eine Funktions-App

- Eine Ressourcengruppe

- Verbrauchsplan

- Speicherkonto

- Benutzerdefinierten Cron-Zeitplan festlegen (optional).

- Öffnen Sie function_app.py in einem Editor.

- Suchen Sie die Zeile: @app.timer_trigger(schedule="0 0 */8 * * *",

- Ersetzen Sie den Terminplan durch Ihren benutzerdefinierten Cron-Ausdruck und speichern Sie die Datei.

Einsatz

- Öffnen Sie ein Terminal im Paketverzeichnis (adls_azure_function).

- Führen Sie den folgenden Bereitstellungsbefehl aus:

- func azure functionapp publish <FunctionAppName> --build remote --python --clean

- Ersetzen Sie <FunctionAppName> durch den Namen Ihrer Azure-Funktions-App in Ihrem Azure-Abonnement.

Validierung

- Stellen Sie sicher, dass die Bereitstellung erfolgreich ist, indem Sie im Azure-Portal den Status Ihrer Funktions-App überprüfen.

- Überwachen Sie Protokolle, um zu überprüfen, ob die Funktion wie erwartet ausgeführt wird.

Herstellen einer Verbindung mit ADLS mithilfe von Python

Übersicht

Dieser Leitfaden enthält detaillierte Anweisungen zur Einrichtung und Verwendung des Delta Sharing-Integrationspakets auf einem Windows-Betriebssystem , um Daten nahtlos in Ihre Workflows mit Procore Analytics zu integrieren. Das Paket unterstützt mehrere Ausführungsoptionen, so dass Sie die gewünschte Konfiguration und Integrationsmethode auswählen können.

Voraussetzungen

Stellen Sie sicher, dass Sie über Folgendes verfügen, bevor Sie fortfahren:

- Procore Analytics 2.0 SKU

- Delta-Sharing-Pofile-Datei:

Rufen Sie Ihre *.share-Datei mit den Anmeldedatenfür die Deltafreigabe ab. Kopieren Sie es der Einfachheit halber in das Paketverzeichnis. - Python-Umgebung: Installieren Sie Python 3 und pip auf Ihrem System.

- Laden Sie Python herunter.

- Alternativ können Sie auch den Microsoft Store verwenden.

Schritte

- Vorbereiten des Pakets

- Installieren von Abhängigkeiten

- Konfiguration generieren

- Konfigurieren von Cron-Jobs und sofortiger Ausführung

- Ausführung und Wartung

Vorbereiten des Pakets

- Erstellen Sie eine neue Datei mit dem Namen config.share mit Ihren Delta Share-Anmeldedaten im JSON-Format.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxxxx",

"endpoint": "https://nvirginia.cloud.databricks.c...astores/xxxxxx

}

- Abrufen von Pflichtfeldern.

Anmerkung: Diese Details können über die Procore Analytics-Webanwendung abgerufen werden.- ShareCredentialsVersion: Versionsnummer (derzeit 1).

- BearerToken: Ihr Delta Share-Zugriffstoken.

- Endpunkt: Die URL Ihres Delta Share-Endpunkts.

- Laden Sie das Paket herunter und extrahieren Sie es.

- Entpacken Sie das Paket in ein Verzeichnis Ihrer Wahl.

- Kopieren Sie die *.share Delta Sharing-Profildatei in das Paketverzeichnis, um den Zugriff zu erleichtern.

Installieren von Abhängigkeiten

- Öffnen Sie ein Terminal im Paketverzeichnis.

- Führen Sie den folgenden Befehl aus, um die Abhängigkeiten zu installieren:

- pip install -r requirements.txt

Konfiguration generieren

- Generieren Sie die Datei config.yaml , indem Sie python user_exp.py ausführen:

Dieses Skript hilft beim Generieren der Datei config.yaml, die die erforderlichen Anmeldedaten und Einstellungen enthält. - Bei der Konfiguration der Datenquelle werden Sie aufgefordert, Folgendes anzugeben:

- Liste der Tabellen (durch Kommas getrennt).

- Lassen Sie das Feld leer, um alle Tabellen zu synchronisieren.

Beispiel: 'Tabelle1, Tabelle2, Tabelle3'. - Pfad zu Ihrer 'config.share' Datei.

- Zum ersten Mal geben Sie Ihre Anmeldedaten wie den Speicherort der Delta Share-Quellkonfiguration, Tabellen, Datenbank, Host usw. an.

Anmerkung: Danach können Sie die Konfiguration manuell oder durch das laufende Python-user_exp.py wiederverwenden oder aktualisieren.

Konfigurieren von Cron-Jobs und sofortiger Ausführung (optional)

- Entscheiden Sie, ob Sie einen Cronjob für die automatische Ausführung einrichten möchten.

- Stellen Sie einen Cron-Zeitplan bereit:

- Format: * * * * * ( Minute, Stunde, Monatstag, Monat, Wochentag).

- Beispiel für die tägliche Ausführung um 2 Uhr morgens: 0 2 * * *

- Um die Planungsprotokolle zu überprüfen, wird die Datei 'procore_scheduling.log' erstellt, sobald die Terminplanung eingerichtet ist.

Sie können die Zeitplanung auch überprüfen, indem Sie den folgenden Befehl im Terminal ausführen:

Für Linux und MacOs:

Bearbeiten/Löschen - Bearbeiten Sie den Terminplanungs-Cron mit:

'''Bash

EDITOR=nano crontab -e

```

- Nachdem Sie den obigen Befehl ausgeführt haben, sollten Sie etwas Ähnliches wie das folgende sehen:

- 2 * * * * /Benutzer/your_user/snowflake/venv/bin/python /Benutzer/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | während der gelesenen Zeile; do echo "$(date) - $line"; Erledigt >> /Benutzer/your_user/snowflake/sql_server_python/procore_scheduling.log # procore-data-import

- Sie können auch den Zeitplan anpassen oder die gesamte Zeile löschen, um zu verhindern, dass sie nach Zeitplan ausgeführt wird.

Für Windows:

- Überprüfen Sie, ob die Terminplanaufgabe erstellt wurde:

'''Powershell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - So bearbeiten/löschen Sie die Planungsaufgabe:

Öffnen Sie den Taskplaner:- Drücken Sie Win + R, geben Sie taskschd.msc ein. und drücken Sie die Eingabetaste.

- Navigieren Sie zu den geplanten Aufgaben.

- Erweitern Sie im linken Bereich die Taskplaner-Bibliothek.

- Suchen Sie nach dem Ordner, in dem Ihre Aufgabe gespeichert ist (z. B. Taskplaner-Bibliothek oder ein benutzerdefinierter Ordner).

- Finden Sie Ihre Aufgabe:

- Suchen Sie nach dem Aufgabennamen ProcoreDeltaShareScheduling.

- Klicken Sie darauf, um die Details im unteren Bereich anzuzeigen.

- Überprüfen Sie den Zeitplan:

- Überprüfen Sie die Registerkarte Trigger, um zu sehen, wann die Aufgabe ausgeführt werden soll.

- Überprüfen Sie die Registerkarte Verlauf, um die letzten Ausführungen zu bestätigen.

- So löschen Sie die Aufgabe:

- Löschen Sie die Aufgabe aus der GUI.

Frage zur sofortigen Ausführung:

- Option zum Ausführen eines Skripts zum Kopieren von Daten unmittelbar nach der Konfiguration.

- Nach dem Generieren der config.yaml, Die CLI kann jederzeit unabhängig ausgeführt werden, indem je nach Paket ein Skript zum Kopieren von Daten ausgeführt wird. Siehe Beispiele unten:

Python-delta_share_to_azure_panda.py

ODER

python delta_share_to_sql_spark.py

ODER

python delta_share_to_azure_dfs_spark.py

Ausführung und Wartung

Häufige Probleme und Lösungen

- Cron Job Einrichtung:

- Stellen Sie sicher, dass die Systemberechtigungen korrekt konfiguriert sind.

- Überprüfen Sie die Systemprotokolle, wenn der Auftrag nicht ausgeführt werden kann.

- Überprüfen Sie, ob das Skript über Ausführungsberechtigungen delta_share_to_azure_panda.py verfügt.

- Konfigurationsdatei:

- Stellen Sie sicher, dass sich die Datei config.yaml im selben Verzeichnis wie das Skript befindet.

- Sichern Sie die Datei, bevor Sie Änderungen vornehmen.

Unterstützen

Für weitere Hilfe:

- Überprüfen Sie die Skriptprotokolle auf detaillierte Fehlermeldungen.

- Überprüfen Sie die Datei config.yaml auf Fehlkonfigurationen.

- Wenden Sie sich an Ihren Systemadministrator, wenn Sie Fragen zu Berechtigungen haben.

- Wenden Sie sich bei Problemen im Zusammenhang mit dem Delta Share-Zugriff an den Procore Support.

- Überprüfen Sie das Protokoll auf fehlgeschlagene Tabellen: failed_tables.log.

Hinweise

- Sichern Sie immer Ihre Konfigurationsdateien, bevor Sie Änderungen vornehmen.

- Testen Sie neue Konfigurationen in einer Nicht-Produktionsumgebung, um Unterbrechungen zu vermeiden.

Herstellen einer Verbindung mit ADLS mithilfe von Spark

Übersicht

Dieser Leitfaden enthält detaillierte Anweisungen zur Einrichtung und Verwendung des Delta Sharing-Integrationspakets auf einem Windows-Betriebssystem , um Daten nahtlos in Ihre Workflows mit Procore Analytics zu integrieren. Das Paket unterstützt mehrere Ausführungsoptionen, so dass Sie die gewünschte Konfiguration und Integrationsmethode auswählen können.

Voraussetzungen

Stellen Sie sicher, dass Sie über Folgendes verfügen, bevor Sie fortfahren:

- Procore Analytics 2.0 SKU

- Delta-Sharing-Pofile-Datei:

Rufen Sie Ihre *.share-Datei mit den Anmeldedatenfür die Deltafreigabe ab. Kopieren Sie es der Einfachheit halber in das Paketverzeichnis. - Python-Umgebung: Installieren Sie Python 3 und pip auf Ihrem System.

- Laden Sie Python herunter.

- Alternativ können Sie auch den Microsoft Store verwenden.

Schritte

- Vorbereiten des Pakets

- Installieren von Abhängigkeiten

- Konfiguration generieren

- Konfigurieren von Cron-Jobs und sofortiger Ausführung

- Ausführung und Wartung

Vorbereiten des Pakets

- Erstellen Sie eine neue Datei mit dem Namen config.share mit Ihren Delta Share-Anmeldedaten im JSON-Format.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxxxx",

"endpoint": "https://nvirginia.cloud.databricks.c...astores/xxxxxx

}

- Abrufen von Pflichtfeldern.

Anmerkung: Diese Details können über die Webanwendung von Procore Analytics abgerufen werden.- ShareCredentialsVersion: Versionsnummer (derzeit 1).

- BearerToken: Ihr Delta Share-Zugriffstoken.

- Endpunkt: Die URL Ihres Delta Share-Endpunkts.

- Laden Sie das Paket herunter und extrahieren Sie es.

- Entpacken Sie das Paket in ein Verzeichnis Ihrer Wahl.

- Kopieren Sie die *.share Delta Sharing-Profildatei in das Paketverzeichnis, um den Zugriff zu erleichtern.

Installieren von Abhängigkeiten

- Öffnen Sie ein Terminal im Paketverzeichnis.

- Führen Sie den folgenden Befehl aus, um die Abhängigkeiten zu installieren:

- pip install -r requirements.txt

Konfiguration generieren

- Generieren Sie die Datei config.yaml , indem Sie python user_exp.py ausführen:

Dieses Skript hilft beim Generieren der Datei config.yaml, die die erforderlichen Anmeldedaten und Einstellungen enthält. - Bei der Konfiguration der Datenquelle werden Sie aufgefordert, Folgendes anzugeben:

- Liste der Tabellen (durch Kommas getrennt).

- Lassen Sie das Feld leer, um alle Tabellen zu synchronisieren.

Beispiel: 'Tabelle1, Tabelle2, Tabelle3'. - Pfad zu Ihrer 'config.share' Datei.

- Zum ersten Mal geben Sie Ihre Anmeldedaten wie den Speicherort der Delta Share-Quellkonfiguration, Tabellen, Datenbank, Host usw. an.

Anmerkung: Danach können Sie die Konfiguration manuell oder durch das laufende Python-user_exp.py wiederverwenden oder aktualisieren.

Konfigurieren von Cron-Jobs und sofortiger Ausführung (optional)

- Entscheiden Sie, ob Sie einen Cronjob für die automatische Ausführung einrichten möchten.

- Stellen Sie einen Cron-Zeitplan bereit:

- Format: * * * * * ( Minute, Stunde, Monatstag, Monat, Wochentag).

- Beispiel für die tägliche Ausführung um 2 Uhr morgens: 0 2 * * *

- Um die Planungsprotokolle zu überprüfen, wird die Datei 'procore_scheduling.log' erstellt, sobald die Terminplanung eingerichtet ist.

Sie können die Zeitplanung auch überprüfen, indem Sie den folgenden Befehl im Terminal ausführen:

Für Linux und MacOs:

Bearbeiten/Löschen - Bearbeiten Sie den Terminplanungs-Cron mit:

'''Bash

EDITOR=nano crontab -e

```

- Nachdem Sie den obigen Befehl ausgeführt haben, sollten Sie etwas Ähnliches wie das folgende sehen:

- 2 * * * * /Benutzer/your_user/snowflake/venv/bin/python /Benutzer/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | während der gelesenen Zeile; do echo "$(date) - $line"; Erledigt >> /Benutzer/your_user/snowflake/sql_server_python/procore_scheduling.log # procore-data-import

- Sie können auch den Zeitplan anpassen oder die gesamte Zeile löschen, um zu verhindern, dass sie nach Zeitplan ausgeführt wird.

Für Windows:

- Überprüfen Sie, ob die Terminplanaufgabe erstellt wurde:

'''Powershell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - So bearbeiten/löschen Sie die Planungsaufgabe:

Öffnen Sie den Taskplaner:- Drücken Sie Win + R, geben Sie taskschd.msc ein. und drücken Sie die Eingabetaste.

- Navigieren Sie zu den geplanten Aufgaben.

- Erweitern Sie im linken Bereich die Taskplaner-Bibliothek.

- Suchen Sie nach dem Ordner, in dem Ihre Aufgabe gespeichert ist (z. B. Taskplaner-Bibliothek oder ein benutzerdefinierter Ordner).

- Finden Sie Ihre Aufgabe:

- Suchen Sie nach dem Aufgabennamen ProcoreDeltaShareScheduling.

- Klicken Sie darauf, um die Details im unteren Bereich anzuzeigen.

- Überprüfen Sie den Zeitplan:

- Überprüfen Sie die Registerkarte Trigger, um zu sehen, wann die Aufgabe ausgeführt werden soll.

- Überprüfen Sie die Registerkarte Verlauf, um die letzten Ausführungen zu bestätigen.

- So löschen Sie die Aufgabe:

- Löschen Sie die Aufgabe aus der GUI.

Frage zur sofortigen Ausführung:

- Option zum Ausführen eines Skripts zum Kopieren von Daten unmittelbar nach der Konfiguration.

- Nach dem Generieren der config.yaml, Die CLI kann jederzeit unabhängig ausgeführt werden, indem je nach Paket ein Skript zum Kopieren von Daten ausgeführt wird. Siehe Beispiele unten:

Python-delta_share_to_azure_panda.py

ODER

python delta_share_to_sql_spark.py

ODER

python delta_share_to_azure_dfs_spark.py

Ausführung und Wartung

Häufige Probleme und Lösungen

- Cron Job Einrichtung:

- Stellen Sie sicher, dass die Systemberechtigungen korrekt konfiguriert sind.

- Überprüfen Sie die Systemprotokolle, wenn der Auftrag nicht ausgeführt werden kann.

- Überprüfen Sie, ob das Skript über Ausführungsberechtigungen delta_share_to_azure_panda.py verfügt.

- Konfigurationsdatei:

- Stellen Sie sicher, dass sich die Datei config.yaml im selben Verzeichnis wie das Skript befindet.

- Sichern Sie die Datei, bevor Sie Änderungen vornehmen.

Unterstützen

Für weitere Hilfe:

- Überprüfen Sie die Skriptprotokolle auf detaillierte Fehlermeldungen.

- Überprüfen Sie die Datei config.yaml auf Fehlkonfigurationen.

- Wenden Sie sich an Ihren Systemadministrator, wenn Sie Fragen zu Berechtigungen haben.

- Wenden Sie sich bei Problemen im Zusammenhang mit dem Delta Share-Zugriff an den Procore Support.

- Überprüfen Sie das Protokoll auf fehlgeschlagene Tabellen: failed_tables.log.

Hinweise

- Sichern Sie immer Ihre Konfigurationsdateien, bevor Sie Änderungen vornehmen.

- Testen Sie neue Konfigurationen in einer Nicht-Produktionsumgebung, um Unterbrechungen zu vermeiden.

Herstellen einer Verbindung mit Fabric Lakehouse mithilfe von Data Factory

Übersicht

Die Integration der Delta-Freigabe in Microsoft Fabric Data Factory ermöglicht den nahtlosen Zugriff auf und die Verarbeitung freigegebener Delta-Tabellen für Ihre Analyse-Workflows mit Procore Analytics 2.0. Delta Sharing, ein offenes Protokoll für die sichere Datenzusammenarbeit, stellt sicher, dass Unternehmen Daten ohne Duplizierung austauschen können.

Voraussetzungen

- Procore Analytics 2.0 SKU

- Anmeldeinformationen für die Delta-Freigabe:

- Rufen Sie die share.json (oder eine gleichwertige) Delta Sharing-Anmeldedaten Datei von Ihrem Datenanbieter ab.

- Diese Datei sollte Folgendes enthalten:

- Endpunkt-URL: Die URL des Delta-Sharing-Servers.

- Inhaber-Token: Wird für den sicheren Datenzugriff verwendet.

- Microsoft Fabric-Einrichtung:

- Ein Microsoft Fabric-Mandantenkonto mit einem aktiven Abonnement.

- Zugriff auf einen Microsoft Fabric-fähigen Arbeitsbereich.

Schritte

- Wechseln zur Data Factory-Umgebung

- Konfigurieren des Datenflusses

- Durchführen von Datentransformationen

- Validierung und Überwachung

Wechseln zur Data Factory-Umgebung

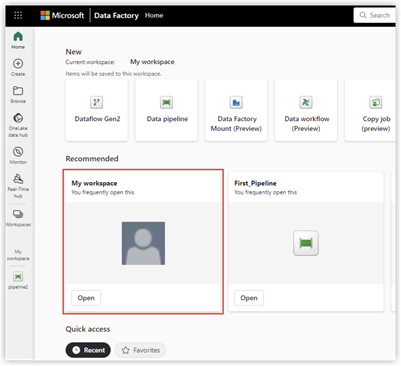

- Navigieren Sie zu Ihrem Microsoft Fabric Workspace.

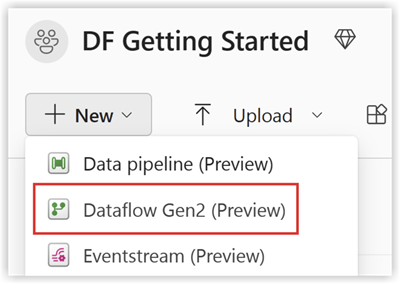

- Wählen Sie Neu und dann Dataflow Gen2 aus.

Konfigurieren des Datenflusses

- Wechseln Sie zum Datenfluss-Editor.

- Klicken Sie auf Daten abrufen und wählen Sie Mehr.

- Wählen Sie unter Neue Quelle die Option Deltafreigabe Andere als Datenquelle aus.

- Geben Sie die folgenden Details ein:

- URL: Aus Ihrer Konfigurationsdatei für die Deltafreigabe.

- Bearer Token: Befindet sich in Ihrer config.share-Datei.

- Klicken Sie auf Weiter und wählen Sie die gewünschten Tabellen aus.

- Klicken Sie auf Erstellen , um die Einrichtung abzuschließen.

Durchführen von Datentransformationen

Nachdem Sie den Datenfluss konfiguriert haben, können Sie nun Transformationen auf die freigegebenen Delta-Daten anwenden. Wählen Sie Ihre Option für die Delta-Freigabe von Daten aus der folgenden Liste aus:

- Datenziel hinzufügen

- Seehaus erstellen/öffnen

Datenziel hinzufügen

- Wechseln Sie zu Data Factory.

- Klicken Sie auf Datenziel hinzufügen.

- Wählen Sie Lakehouse als Ziel aus und klicken Sie auf Weiter.

- Wählen Sie Ihr Zielziel aus und bestätigen Sie mit einem Klick auf Weiter.

Create-Open Lakehouse

- Erstellen/öffnen Sie yourLakehouse und klicken Sie auf Daten abrufen.

- Wählen Sie Neuer Dataflow Gen2 aus.

- Klicken Sie auf Daten abrufen, dann auf Mehr , und suchen Sie nach Delta Sharing.

- Geben Sie das URL-Bearertoken aus Ihrer config.share-Datei ein, und wählen Sie dann Next aus.

- Wählen Sie Ihre Daten/Tabellen zum Herunterladen aus und klicken Sie auf Weiter.

- Nach diesen Manipulationen sollten Sie alle ausgewählten Daten in Ihrem Fabric Lakehouse haben.

Validierung und Überwachung

Testen Sie Ihre Datenpipelines und -flüsse, um eine reibungslose Ausführung zu gewährleisten. Verwenden von Überwachungstools in Daten

Factory, um den Fortschritt und die Protokolle für jede Aktivität zu verfolgen.

Herstellen einer Verbindung mit Fabric Lakehouse mithilfe von Fabric-Notizbüchern

Übersicht

Die Verwendung von Data Factory in Microsoft Fabric mit Delta Sharing ermöglicht die nahtlose Integration und Verarbeitung freigegebener Delta-Tabellen als Teil Ihrer Analyse-Workflows mit Procore Analytics 2.0. Delta Sharing ist ein offenes Protokoll für den sicheren Datenaustausch, das die Zusammenarbeit zwischen Unternehmen ohne Duplizierung von Daten ermöglicht.

Dieser Leitfaden führt Sie durch die Schritte zum Einrichten und Verwenden von Data Factory in Fabric mit Delta Sharing, wobei Notebooks zum Verarbeiten und Exportieren von Daten in ein Lakehouse verwendet werden.

Voraussetzungen

- Procore Analytics 2.0 SKU

- Anmeldeinformationen für die Delta-Freigabe:

- Zugriff auf Delta Sharing-Anmeldedaten, die von einem Datenanbieter bereitgestellt werden.

- Eine Freigabeprofildatei (config.share) enthaltend:

- Endpunkt-URL (Delta-Sharing-Server-URL).

- Access Token (Bearer-Token für sicheren Datenzugriff).

- Erstellen Sie die Datei config.yaml mit bestimmten Anmeldedaten.

- Microsoft Fabric-Umgebung:

- Ein Microsoft Fabric-Mandantenkonto mit einem aktiven Abonnement.

- Ein Fabric-fähiger Arbeitsbereich.

- Pakete und Skripte:

- Laden Sie das fabric-lakehouse-Paket herunter. Das Verzeichnis sollte Folgendes enthalten:

- ds_to_lakehouse.py: Notebook-Code.

- readme.md: Anweisungen.

- Laden Sie das fabric-lakehouse-Paket herunter. Das Verzeichnis sollte Folgendes enthalten:

Schritte

Konfiguration einrichten

- Erstellen der Datei config.yaml und definieren Sie die Konfiguration in der folgenden Struktur

source_config:

config_path: Pfad/zu/Ihrem/delta-sharing-credentials-file.share

tables: # Optional - Lassen Sie das Feld leer, um alle Tabellen zu verarbeiten

- table_name1

- table_name2

target_config:

lakehouse_path: path/to/your/fabric/lakehouse/Tables/ # Pfad zum Fabric Lakehouse

Richten Sie Ihr Seehaus ein

- Öffnen Sie Ihren Microsoft Fabric-Arbeitsbereich.

- Navigieren Sie zu Ihrem Lakehouse und klicken Sie auf Notizbuch öffnen und dann auf Neues Notizbuch.

- Wenn Sie den Wert in config.yaml#lakehouse_path nicht kennen, Sie können es vom Bildschirm kopieren.

- Klicken Sie auf die Ellipse auf Dateien, und wählen Sie ABFS-Pfad kopieren aus:

3. Kopieren Sie den Code der ds_to_lakehouse.py und fügen Sie ihn in das Notebook-Fenster ein (Pyspark Python):

Der nächste Schritt besteht darin, Ihre eigenen config.yaml und config.share in den Ordner Resources des Lakehouse hochzuladen. Sie können Ihr eigenes Verzeichnis erstellen oder ein eingebautes Verzeichnis verwenden (das bereits von Lakehouse für Ressourcen erstellt wurde):

Das folgende Beispiel zeigt ein integriertes Standardverzeichnis für eine config.yaml-Datei.

Hinweis: Stellen Sie sicher, dass Sie beide Dateien auf derselben Ebene und für die Eigenschaft config_path hochladen:

4. Überprüfen Sie den Code des Notizbuchs, Zeilen 170-175.

Das folgende Beispiel zeigt die notwendigen Zeilenänderungen:

config_path = "./env/config.yaml"

An

config_path = "./builtin/config.yaml"

Da sich die Dateien in einem eingebauten Ordner und nicht in einer benutzerdefinierten Umgebung befinden, sollten Sie Ihre eigene Struktur der Dateien überwachen. Sie können sie in verschiedene Ordner hochladen, aber in solchen Fällen aktualisieren Sie den Code des Notebooks, um die Datei config.yaml richtig zu finden.

5. Klicken Sie auf Zelle ausführen:

Validierung

- Überprüfen Sie nach Abschluss des Auftrags, ob die Daten erfolgreich in Ihr Lakehouse kopiert wurden.

- Überprüfen Sie die angegebenen Tabellen, und stellen Sie sicher, dass die Daten mit den freigegebenen Delta-Tabellen übereinstimmen.

- Warten Sie, bis der Auftrag abgeschlossen ist, es sollten alle Daten kopiert werden.

Herstellen einer Verbindung mit SQL Server mithilfe von Azure Functions

Übersicht

Dieser Leitfaden führt Sie durch das Einrichten und Bereitstellen einer Azure-Funktion für die Integration von Delta Sharing-Daten in Procore Analytics. Die Azure-Funktion ermöglicht effiziente Datenverarbeitungs- und Freigabeworkflows mit Delta Sharing-Profilen.

Voraussetzungen

- Procore Analytics 2.0 SKU.

- Profildatei für die Delta-Freigabe:

- Ihre *.share-Datei mit den Anmeldedatenfür die Deltafreigabe. Legen Sie es der Einfachheit halber in das heruntergeladene Paket.

- Python-Umgebung:

- Sie haben Python 3.9+ und pip auf Ihrem System installiert.

- Azure-Einrichtung:

- Die Azure CLI ist installiert und angemeldet.

- Azure Functions Kerntools installiert.

Schritte

- Prepare the Package

- Install Dependencies

- Generate Configuration

- Azure CLI Setup

- Install Azure Functions Core Tools

- Prepare the Azure Function

- Deployment

- Validation

Vorbereiten des Pakets

- Laden Sie das erforderliche Paket herunter (adls_azure_function oder sql_server_azure_function).

- Extrahieren Sie die Paketdateien in ein lokales Verzeichnis.

- Platzieren Sie die Delta-Sharing-Datei:

- Kopieren Sie Ihre *.share Delta Sharing-Profildatei in das extrahierte Verzeichnis.

Installieren von Abhängigkeiten

- Öffnen Sie ein Terminal im Paketverzeichnis.

- Führen Sie den folgenden Befehl aus, um die erforderlichen Python-Abhängigkeiten zu installieren:

- pip install -r requirements.txt

Konfiguration generieren

- Generieren Sie die Datei config.yaml , indem Sie Folgendes ausführen:

- Python-user_exp.py

- Das Skript fordert Sie auf, Anmeldedaten einzugeben, z. B.:

- Tabellen

- Name der Datenbank

- Gastgeber

- Zusätzliche Anmeldedaten.

- Die Konfiguration kann wiederverwendet oder manuell oder durch erneutes Ausführen von python user_exp.pyaktualisiert werden.

Einrichtung der Azure CLI

- Melden Sie sich bei Azure an.

- Führen Sie den folgenden Befehl aus, um sich anzumelden:

az login - Überprüfen des Azure-Kontos:

- az account show

- Wenn der Befehl az nicht verfügbar ist, installieren Sie die Azure CLI, indem Sie die Anweisungen befolgen, die Sie hier finden: Microsoft Learn.

Installieren von Azure Functions Kerntools

Gehe zu

Hier finden Sie Anweisungen zum Installieren von Azure Functions Kerntools.Vorbereiten der Azure-Funktion

- Verwenden SieSo erstellen Sie Folgendes:

- Eine Funktions-App

- Eine Ressourcengruppe

- Verbrauchsplan

- Speicherkonto

- Benutzerdefinierten Cron-Zeitplan festlegen (optional).

- Öffnen Sie function_app.py in einem Editor.

- Suchen Sie die Zeile: @app.timer_trigger(schedule="0 0 */8 * * *",

- Ersetzen Sie den Terminplan durch Ihren benutzerdefinierten Cron-Ausdruck und speichern Sie die Datei.

Einsatz

- Öffnen Sie ein Terminal im Paketverzeichnis (adls_azure_function).

- Führen Sie den folgenden Bereitstellungsbefehl aus:

- func azure functionapp publish <FunctionAppName> --build remote --python --clean

- Ersetzen Sie <FunctionAppName> durch den Namen Ihrer Azure-Funktions-App in Ihrem Azure-Abonnement.

Validierung

- Stellen Sie sicher, dass die Bereitstellung erfolgreich ist, indem Sie im Azure-Portal den Status Ihrer Funktions-App überprüfen.

- Überwachen Sie Protokolle, um zu überprüfen, ob die Funktion wie erwartet ausgeführt wird.

Herstellen einer Verbindung mit SQL Server mithilfe von Data Factory

Übersicht

Dieses Dokument enthält Schritt-für-Schritt-Anleitungen zum Einrichten einer Datenpipeline in Microsoft Fabric zum Übertragen von Daten von Delta Share in ein SQL-Warehouse. Diese Konfiguration ermöglicht eine nahtlose Datenintegration zwischen Delta Lake-Quellen und SQL-Zielen.

Voraussetzungen

- Aktives Microsoft Fabric-Konto mit den entsprechenden Berechtigungen.

- Delta Share-Anmeldedaten.

- Anmeldedaten für das SQL-Warehouse.

- Zugriff auf Data Flow Gen2 in Fabric.

Schritte

- Zugriff auf Data Flow Gen2

- Konfigurieren der Datenquelle export-to-sql-server-using-data-factory#Configure_Data_Source

- Einrichten der Delta Share-Verbindung

- Datenziel konfigurieren

- Finalisieren und Bereitstellen

- Verifizierung

- Problembehebung

Zugriff auf Data Flow Gen2

- Melden Sie sich bei Ihrem Microsoft Fabric-Konto an.

- Navigieren Sie zum Arbeitsbereich.

- Wählen Sie aus den verfügbaren Optionen "Datenfluss Gen2" aus.

Konfigurieren der Datenquelle

- Klicken Sie auf "Daten aus einer anderen Quelle", um die Konfiguration zu starten.

- Gehen Sie auf dem Bildschirm Daten abrufen wie folgt vor:

- Suchen Sie die Suchleiste mit der Bezeichnung "Datenquelle auswählen".

- Geben Sie "Delta Sharing" in das Suchfeld ein.

- Wählen Sie in den Ergebnissen Deltafreigabe aus.

Einrichten der Delta Share-Verbindung

- Geben Sie Ihre Delta Share-Anmeldedaten ein, wenn Sie dazu aufgefordert werden.

- Stellen Sie sicher, dass alle erforderlichen Felder korrekt ausgefüllt sind.

- Überprüfen Sie, wenn möglich, die Verbindung.

- Klicken Sie auf "Weiter", um fortzufahren.

- Überprüfen Sie die Liste der verfügbaren Tabellen:

- Es werden alle Tabellen angezeigt, auf die Sie Zugriff haben.

- Wählen Sie die gewünschten Tabellen für die Übertragung aus.

Datenziel konfigurieren

- Klicken Sie auf "Datenziel hinzufügen".

- Wählen Sie als Ziel "SQL-Warehouse" aus.

- Geben Sie die SQL-Anmeldedaten ein:

- Server-Details.

- Informationen zur Authentifizierung.

- Datenbank-Spezifikationen.

- Überprüfen Sie die Verbindungseinstellungen.

Finalisieren und Bereitstellen

- Überprüfen Sie alle Konfigurationen.

- Klicken Sie auf "Veröffentlichen", um den Datenfluss bereitzustellen.

- Warten Sie auf die Bestätigungsmeldung.

Verifizierung

- Greifen Sie auf Ihr SQL-Warehouse zu.

- Stellen Sie sicher, dass die Daten verfügbar und richtig strukturiert sind.

- Führen Sie Testabfragen aus, um die Datenintegrität sicherzustellen.

Problembehebung

Häufige Probleme und Lösungen:

- Verbindungsfehler: Überprüfen Sie die Anmeldedaten und die Netzwerkverbindung.

- Fehlende Tabellen: Überprüfen Sie die Delta-Freigabeberechtigungen.

- Leistungsprobleme: Überprüfen Sie die Einstellungen für die Ressourcenzuweisung und -optimierung.

Herstellen einer Verbindung mit SQL Server mithilfe von Fabric Notebook

Übersicht

Die Verwendung von Data Factory in Microsoft Fabric mit Delta Sharing ermöglicht die nahtlose Integration und Verarbeitung freigegebener Delta-Tabellen als Teil Ihrer Analyse-Workflows mit Procore Analytics 2.0. Delta Sharing ist ein offenes Protokoll für den sicheren Datenaustausch, das die Zusammenarbeit zwischen Unternehmen ohne Duplizierung von Daten ermöglicht.

Dieser Leitfaden führt Sie durch die Schritte zum Einrichten und Verwenden von Data Factory in Fabric mit Delta Sharing, wobei Notebooks zum Verarbeiten und Exportieren von Daten in ein Lakehouse verwendet werden.

Voraussetzungen

- Procore Analytics 2.0 SKU

- Anmeldeinformationen für die Delta-Freigabe:

- Zugriff auf Delta Sharing-Anmeldedaten, die von einem Datenanbieter bereitgestellt werden.

- Eine Freigabeprofildatei (config.share) enthaltend:

- Endpunkt-URL (Delta-Sharing-Server-URL).

- Access Token (Bearer-Token für sicheren Datenzugriff).

- Erstellen Sie die Datei config.yaml mit bestimmten Anmeldedaten.

- Microsoft Fabric-Umgebung:

- Ein Microsoft Fabric-Mandantenkonto mit einem aktiven Abonnement.

- Ein Fabric-fähiger Arbeitsbereich.

- Pakete und Skripte:

- Laden Sie das fabric-lakehouse-Paket herunter. Das Verzeichnis sollte Folgendes enthalten:

- ds_to_lakehouse.py: Notebook-Code.

- readme.md: Anweisungen.

- Laden Sie das fabric-lakehouse-Paket herunter. Das Verzeichnis sollte Folgendes enthalten:

Schritte

Konfiguration einrichten

- Erstellen der Datei config.yaml und definieren Sie die Konfiguration in der folgenden Struktur

source_config:

config_path: Pfad/zu/Ihrem/delta-sharing-credentials-file.share

tables: # Optional - Lassen Sie das Feld leer, um alle Tabellen zu verarbeiten

- table_name1

- table_name2

target_config:

lakehouse_path: path/to/your/fabric/lakehouse/Tables/ # Pfad zum Fabric Lakehouse

Richten Sie Ihr Seehaus ein

- Öffnen Sie Ihren Microsoft Fabric-Arbeitsbereich.

- Navigieren Sie zu Ihrem Lakehouse und klicken Sie auf Notizbuch öffnen und dann auf Neues Notizbuch.

- Wenn Sie den Wert in config.yaml#lakehouse_path nicht kennen, Sie können es vom Bildschirm kopieren.

- Klicken Sie auf die Ellipse auf Dateien, und wählen Sie ABFS-Pfad kopieren aus:

3. Kopieren Sie den Code der ds_to_lakehouse.py und fügen Sie ihn in das Notebook-Fenster ein (Pyspark Python):

Der nächste Schritt besteht darin, Ihre eigenen config.yaml und config.share in den Ordner Resources des Lakehouse hochzuladen. Sie können Ihr eigenes Verzeichnis erstellen oder ein eingebautes Verzeichnis verwenden (das bereits von Lakehouse für Ressourcen erstellt wurde):

Das folgende Beispiel zeigt ein integriertes Standardverzeichnis für eine config.yaml-Datei.

Hinweis: Stellen Sie sicher, dass Sie beide Dateien auf derselben Ebene und für die Eigenschaft config_path hochladen:

4. Überprüfen Sie den Code des Notizbuchs, Zeilen 170-175.

Das folgende Beispiel zeigt die notwendigen Zeilenänderungen:

config_path = "./env/config.yaml"

An

config_path = "./builtin/config.yaml"

Da sich die Dateien in einem eingebauten Ordner und nicht in einer benutzerdefinierten Umgebung befinden, sollten Sie Ihre eigene Struktur der Dateien überwachen. Sie können sie in verschiedene Ordner hochladen, aber in solchen Fällen aktualisieren Sie den Code des Notebooks, um die Datei config.yaml richtig zu finden.

5. Klicken Sie auf Zelle ausführen:

Validierung

- Überprüfen Sie nach Abschluss des Auftrags, ob die Daten erfolgreich in Ihr Lakehouse kopiert wurden.

- Überprüfen Sie die angegebenen Tabellen, und stellen Sie sicher, dass die Daten mit den freigegebenen Delta-Tabellen übereinstimmen.

- Warten Sie, bis der Auftrag abgeschlossen ist, es sollten alle Daten kopiert werden.

Herstellen einer Verbindung mit Databricks

Hinweis

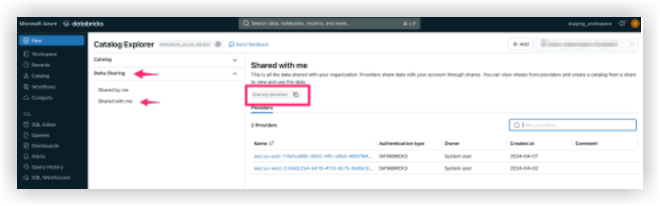

Diese Verbindungsmethode wird in der Regel von Datenexperten verwendet.- Melden Sie sich bei Ihrer Databricks-Umgebung an.

- Navigieren Sie zum Abschnitt Katalog .

- Wählen Sie im oberen Menü die Option Deltafreigabe aus .

- Wählen Sie Für mich freigegeben aus.

- Kopieren Sie die für Sie bereitgestellte Freigabe-ID .

- Geben Sie die Freigabe-Kennung an das Procore-Support-Team weiter.

Anmerkung: Sobald die Freigabe-ID zum Procore-System hinzugefügt wurde, wird die Procore Databricks-Verbindung auf der Registerkarte "Für mich freigegeben " unter "Anbieter" in Ihrer Databricks-Umgebung angezeigt. Es kann bis zu 24 Stunden dauern, bis die Daten angezeigt werden.

- Wenn Ihre Procore Databricks-Verbindung auf der Registerkarte "Für mich freigegeben " sichtbar wird, wählen Sie den Procore-Indentifier aus und klicken Sie auf Katalog erstellen.

- Geben Sie Ihren bevorzugten Namen für den freigegebenen Katalog ein und klicken Sie auf Erstellen.

- Ihr freigegebener Katalog und Ihre Tabellen werden nun unter dem angegebenen Namen in der Katalog-Explorer.

Bitte wenden Sie sich an den Procore Support, wenn Sie Fragen haben oder Hilfe benötigen.

Herstellen einer Verbindung mit Snowflake mithilfe von Python

Übersicht

Das Procore Analytics Cloud Connect Access Tool ist eine Befehlszeilenschnittstelle (CLI), mit der Sie Datenübertragungen von Procore zu Snowflake konfigurieren und verwalten können.

Es besteht aus zwei Hauptkomponenten:

- user_exp.py: Dienstprogramm zur Konfigurationseinrichtung

- ds_to_snowflake.py: Skript zur Datensynchronisierung

Voraussetzungen

- Python ist auf Ihrem System installiert

- Zugang zu Procore Delta Share

- Anmeldedaten für das Snowflake-Konto

- Installieren Sie die erforderlichen Abhängigkeiten mit:

- pip install -r requirements.txt

Schritte

- Erstkonfiguration

- Daten-Synchronisation

- Konfiguration der Delta Share-Quelle

- Konfiguration des Snowflake-Ziels

- Optionen für die Planung

- Best Practices

- Problembehebung

Erstkonfiguration

Führen Sie das Konfigurationsdienstprogramm mit Python user_exp.py aus.

Daten-Synchronisation

Nach der Konfiguration haben Sie zwei Möglichkeiten, die Datensynchronisierung auszuführen:

- Direkte Ausführung:

- Python-ds_to_snowflake.py

- Geplante Ausführung

- Wenn Sie dies während des Setups konfigurieren, wird der Auftrag automatisch gemäß Ihrem Cron-Zeitplan ausgeführt.

- Um die Planungsprotokolle zu überprüfen, wird die Datei 'procore_scheduling.log' erstellt, sobald die Planung eingerichtet wird.

- Sie können die Planung auch überprüfen, indem Sie den folgenden Befehl im Terminal ausführen:

Für Linux und MacOS:

- Bearbeiten/Löschen - Bearbeiten Sie den Terminplanungs-Cron mit:

'''Bash

EDITOR=nano crontab -e

``` - Nachdem Sie den obigen Befehl ausgeführt haben, sollten Sie etwas Ähnliches wie das folgende sehen:

2 * * * *

/Benutzer/your_user/snowflake/venv/bin/python

/Benutzer/your_user/Schneeflocke/sql_server_python/connection_config.py

2>&1 | während der gelesenen Zeile; do echo "$(date) - $line"; Fertig>>

/Benutzer/your_user/Schneeflocke/sql_server_python/procore_scheduling.log # Procore-Daten-Import - Sie können auch den Zeitplan anpassen oder die gesamte Zeile löschen, um zu verhindern, dass sie nach Zeitplan ausgeführt wird.

Für Windows:

- Überprüfen Sie, ob die Terminplanaufgabe erstellt wurde:

```

PowerShell (PowerShell)

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

```

- Um die Planungsaufgabe zu bearbeiten/zu löschen , öffnen Sie den Taskplaner.

- Drücken Sie Win + R, geben Sie taskschd.msc ein. und drücken Sie die Eingabetaste.

- Navigieren Sie zu den geplanten Aufgaben.

- Erweitern Sie im linken Bereich die Taskplaner-Bibliothek.

- Suchen Sie nach dem Ordner, in dem Ihre Aufgabe gespeichert ist:

Beispiel: Taskplaner-Bibliothek oder ein benutzerdefinierter Ordner. - Finde deine Aufgabe.

- Suchen Sie nach dem Namen der Aufgabe: ProcoreDeltaShareScheduling.

- Klicken Sie darauf, um die Details im unteren Bereich anzuzeigen.

- Überprüfen Sie den Zeitplan:

- Überprüfen Sie die Registerkarte Trigger, um zu sehen, wann die Aufgabe ausgeführt werden soll.

- Überprüfen Sie die Registerkarte Verlauf, um die letzten Ausführungen zu bestätigen.

- So löschen Sie die Aufgabe:

- Löschen Sie die Aufgabe aus der GUI.

Konfiguration der Delta-Freigabe

- Erstellen der config.share-Datei

- Bevor Sie das Konfigurationsdienstprogramm ausführen können, müssen Sie eine config.share-Datei mit Ihren Delta Share-Anmeldedaten erstellen. Die Datei sollte im JSON-Format vorliegen:

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxxxx",

"endpoint": "https://nvirginia.cloud.databricks.c...astores/xxxxxx

}

- Pflichtfelder:

- ShareCredentialsVersion: Versionsnummer (derzeit 1).

- BearerToken: Ihr Delta Share-Zugriffstoken.

- Endpunkt: Die URL Ihres Delta Share-Endpunkts.

- Diese Details können über die Procore-Web-Benutzeroberfläche abgerufen werden.

- Schritte zum Erstellen von config.share:

- Erstellen Sie eine neue Datei mit dem Namen config.share.

- Kopieren Sie die obige JSON-Vorlage.

- Ersetzen Sie die Platzhalterwerte durch Ihre tatsächlichen Anmeldedaten.

- Speichern Sie die Datei an einem sicheren Ort.

- Sie müssen den Pfad zu dieser Datei während der Konfiguration angeben. Bei der Konfiguration der Datenquelle werden Sie aufgefordert, Folgendes anzugeben:

- Liste der Tabellen (durch Kommas getrennt).

- Lassen Sie das Feld leer, um alle Tabellen zu synchronisieren.

- Beispiel: Tabelle1, Tabelle2, Tabelle3.

- Pfad zu Ihrer config.share-Datei .

Snowflake-Konfiguration

Sie müssen die folgenden Snowflake-Details angeben:

- Authentifizierung (wählen Sie eine aus):

- Benutzer-Authentifizierung

- Nutzername

- Passwort (sicher eingegeben)

- Benutzer-Authentifizierung

- Schlüsselpaar-Authentifizierung

- Nutzername

- Dateipfad des privaten Schlüssels

- Passwort für die Datei mit privatem Schlüssel

- Details zur Verbindung:

- Konto-ID

- Name des Lagers

- Name der Datenbank

- Name des Schemas

- Anzahl gleichzeitiger Threads

Optionen für die Planung

Das Tool bietet die Möglichkeit, eine automatische Datensynchronisierung zu planen.

- Cronjob-Konfiguration

- Auswählen, ob Sie ein tägliches Projekt einrichten möchten

- Wenn ja, geben Sie einen Cron-Zeitplan an

- Format: * * * * * (Minute, Stunde, Monat, Monat, Wochentag)

- Beispiel für täglich um 2 Uhr morgens: 0 2 * * *

- Sofortige Ausführung

- Option zum sofortigen Ausführen der ds_to_snowflake.py nach der Konfiguration

- Datei-Struktur

Unset

├── requirements.txt # Abhängigkeiten

├── user_exp.py # Konfigurations-Dienstprogramm

├── ds_to_snowflake.py # Skript zur Datensynchronisierung

├── config.yaml # Generierte Konfiguration

├── config.share # Delta-Share-Konfigurationsdatei

├── procore_scheduling.log # Protokoll der Terminierungsläufe

Beispiel für die Verwendung- Schritt 1: Installieren von Abhängigkeiten

$ pip install -r requirements.txt - Schritt 2: Konfigurationsdienstprogramm ausführen

$ python user_exp.py - Procore Analytics Cloud Connect-Zugriff

- Diese CLI hilft Ihnen bei der Auswahl Ihres Quell- und Zielspeichers für den Zugriff/das Schreiben von Procore-Daten in Snowflake.

- Drücken Sie die Eingabetaste, um fortzufahren.

- Geben Sie die Liste der Tabellen ein (durch Kommas getrennt), lassen Sie sie für alle Tabellen leer: Projekte, Benutzer, Aufgaben.

- Geben Sie den Pfad zu config.share ein: /Pfad/zur/config.share.

- Geben Sie den Benutzernamen ein: snowflake_user.

- Welchen Authentifizierungstyp möchten Sie verwenden? (Benutzer/key_pair): Eingabetaste.

- 1 für Benutzer,

- 2 für Schlüsselpaar:

- 1

- Passwort eingeben: ********

- Konto eingeben: my_account

- Lager eingeben: my_warehouse

- Geben Sie den Datenbanknamen ein: procore_db

- Geben Sie den Schemanamen ein: procore_schema

- Anzahl der Threads eingeben: 4

- Möchten Sie dies als täglichen Job auf cron konfigurieren? (Ja/Nein): Ja

- Geben Sie den Zeitplan im Cron-Format ein (z. B. * * * * * ): 0 2 * * *

- Möchten Sie den Auftrag jetzt ausführen? (Ja/Nein): Ja

- Schritt 3: Manuelle Ausführung (falls erforderlich)

$ python ds_to_snowflake.py

- Schritt 1: Installieren von Abhängigkeiten

- Wiederverwendung von Konfigurationen

Das Tool speichert Ihre Konfiguration in der Datei config.yaml und bietet die Möglichkeit, zuvor gespeicherte Einstellungen wiederzuverwenden:- Die Quellkonfiguration kann wiederverwendet werden.

- Die Zielkonfiguration (Snowflake) kann wiederverwendet werden.

- Sie können wählen, ob Sie beide Konfigurationen unabhängig voneinander aktualisieren möchten.

Bewährte Methoden

- Authentifizierung

- Verwenden Sie, wenn möglich, die Authentifizierung von Schlüsselpaaren.

- Wechseln Sie die Anmeldedaten regelmäßig.

- Verwenden Sie die minimal erforderlichen Berechtigungen.

- Leistung

- Passen Sie die Threadanzahl basierend auf Ihren Systemfunktionen an.

- Beginnen Sie mit einer kleineren Teilmenge von Tabellen zum Testen.

Fehlerbehebung

- Häufige Probleme und Lösungen:

- Ungültiger Authentifizierungstyp

- Stellen Sie sicher, dass Sie entweder "1" (Benutzer) oder "2" (key_pair) auswählen, wenn Sie dazu aufgefordert werden.

- Ungültiger Authentifizierungstyp

- Cronjob einrichten

- Stellen Sie sicher, dass Sie über die entsprechenden Systemberechtigungen verfügen.

- Überprüfen Sie die Systemprotokolle, wenn der Auftrag nicht ausgeführt werden kann.

- Stellen Sie sicher, dass das ds_to_snowflake.py über die richtigen Berechtigungen verfügt.

- Überprüfen Sie die Einrichtung des Cron-Jobs, indem Sie die Systemprotokolle überprüfen:

Siehe Datei 'procore_scheduling.log'.

- Konfigurationsdatei

- Befindet sich im selben Verzeichnis wie das Skript

- Mit dem Namen config.yaml.

- Sichern Sie, bevor Sie Änderungen vornehmen.

- Unterstützen

- Überprüfen Sie die Protokollausgabe des Skripts.

- Überprüfen Sie die Datei config.yaml .